スマホアプリの開発者がAIの学習データをGoogleドライブにアップロードしたところ、Googleアカウントが禁止暴露される事態になってしまいました。

開発者が AI データ内で誤って CSAM を発見しました。 Googleはそのために彼を禁止した

https://www.404media.co/a-developer-accidentally-found-csam-in-ai-data-google-banned-him-for-it/

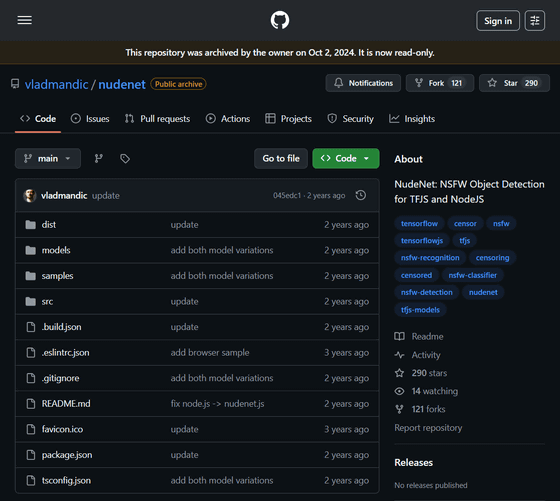

問題のデータは、NSFW検出ツール用のデータセット「NudeNet」。ヌードネットはウィンチェスター6788Reddit やその他のソースからデータを収集し、GitHub で公開し、さまざまな研究者や開発者によって使用されています。

GitHub – vladmandic/nudenet: NudeNet: TFJS および NodeJS の NSFW オブジェクト検出

https://github.com/vladmandic/nudenet

NudeNet を使用していたために、Google アカウントが禁止されました。ブランドこれは、markatlarge 氏が NudeNet データセットをダウンロードして Google ドライブに保存し、NSFW コンテンツを検出するアプリを作成したものです。財布』のベンチマークテストを行っていたそうです。

その後、Google はあなたのアカウントに次のことを通知します。児童性的虐待コンテンツ (CSAM)が含まれています。これは Google のポリシーに対する重大な違反であり、違法である可能性があります。」 彼は、自分がアップロードしたデータに CSAM が含まれていることを知りました。その結果、マルカトラージさんのGoogleアカウントは禁止され、14年間使用していたGmailやアプリのバックエンドとして機能するFirebase、モバイルアプリ収益化プラットフォームのAdMobなどにアクセスできなくなった。

markatlarge氏はGoogleに異議を申し立て、アップロードした問題の画像はNudeNetから入手したものであり、NudeNetは「アダルトコンテンツのみを検出できる信頼できる研究データセット」であると信じていると説明した。

Googleは控訴を認めたものの、アカウント停止はそのままであったため、markatlargeは引き続きGoogleサービスにアクセスできなくなった。そこで再度異議を申し立てたそうですが、これは却下されたようです。

markatlargeのアカウントが削除されたため、国立行方不明児童・搾取児童センターまたはカナダ児童保護センター「NudeNet には CSAM が含まれている」ことが通知されます。さらに、NudeNet は次の場所でホストされていました。学術トレント私たちは彼らに連絡し、プラットフォームからデータセットを削除しました。

連絡を受けたカナダ児童保護センターは独自の調査を実施し、NudeNet には「特定または既知の CSAM 被害者の画像 120 枚以上が含まれている」こと、「思春期前の子供の性器と肛門に焦点を当てた 70 枚近くの画像が含まれていること」、「性行為や十代の若者による性的虐待行為を描いた画像が含まれていること」を発見しました。明らかにとなってしまった。

これに対し、NudeNet著者のwinchester6788氏は「膨大な画像からCSAMを確認したり削除したりするのは基本的に不可能だ」と述べた。言及やってますよ。

一方、NudeNetの利用後にGoogleアカウントを無効にされたマルカトラージ氏は、「問題は、独立系開発者がCSAMの検出に必要なツールにアクセスできない一方、大手IT企業がその機能を独占していることだ」と述べた。 Google などの巨大企業は、CSAM も含まれる LAION-5B のようなデータセットを説明責任なく公然と使用できます。 AI モデルのトレーニングにもそれを使用しています。しかし、私が正当なテストのために NudeNet に触れたとき、問題があったのはそのうち約 700 個だけだったにもかかわらず、Google は私のアカウントから 130,000 個以上のファイルを削除しました。これは安全なシステムではなく、独立した監視や説明責任がありません。」コメントそして独立系開発者は、CSAM 検出に必要なデータセットが入手できないと不満を述べています。

404メディアは、今回の事件は「インターネットから無差別に収集されたAI学習データが、違法な画像が含まれていることに気付かずに使用した人々にどのような影響を与える可能性があるかを示す最新の例」であると報じ、数百万枚の画像からなる学習データから有害な画像を特定することがいかに難しいかを示していると述べた。

なお、404 Mediaがこの状況についてGoogleにコメントを求めたところ、マルカトラル氏のGoogleアカウントは再度調査され、最終的には復元されたそうです。

Googleの広報担当者は404 Mediaに対し、「GoogleはCSAMの拡散防止に尽力しており、この種のコンテンツの拡散を防ぐための強力な保護措置を講じている」とコメントした。この場合、ユーザー アカウントで CSAM が検出されましたが、当社のレビューにより、ユーザーのアップロードは悪意のあるものではないと判断されるはずでした。問題のアカウントは復元されており、引き続きプロセスを改善していきます。」

この記事のタイトルとURLをコピーします